Topic: DeepMind and Blizzard open StarCraft II as an AI research environment

Dosudo deep learning newsletter #4

Editor: George Wu

Resources: 原始post 原始post2 中文post Paper Install

Label: Reinforcement learning

在去年AlphaGo Master 橫掃了人類棋壇之後, DeepMind曾經談到下一個攻克的目標就是StartCraft II. 如今DeepMind及Blizzard 共同推出了星海爭霸2 人工智慧研發環境(SC2LE, StarCraft II learning environment). SC2LE包含了

(1) Blizzard開發的Machine learning API,

(2) 供training用的遊戲紀錄replays,

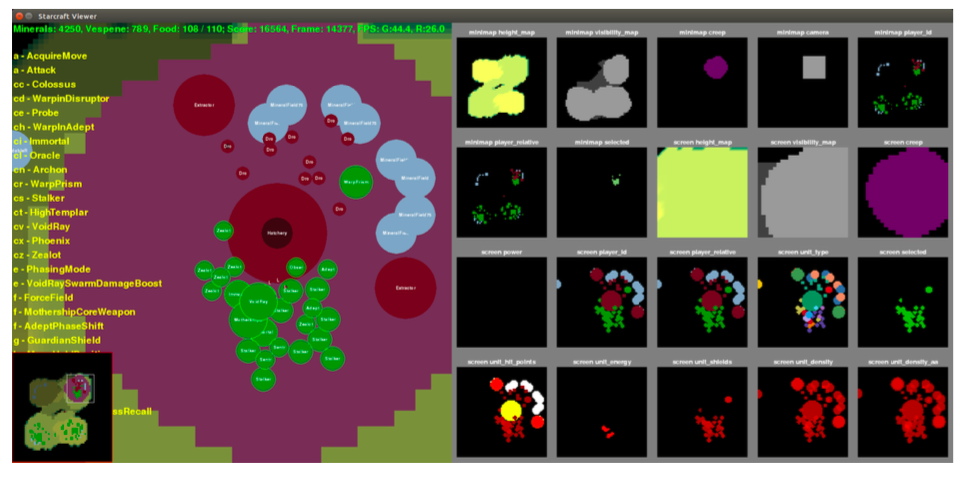

(3) Deepmind開發了python 工具集PySC2, 提供了API讓使用者設計的強化學習agent能夠運行在SC2遊戲裡.

(4) 一連串的迷你遊戲環境讓使用者方便地測試.

以及一篇paper講述了在SC2LE中測試強化學習的一些成果.

SC2LE為強化學習領域帶來了很多新的困難挑戰. 首先這是一個多代理(multi-agent), 以及多玩家的問題, 也由於地圖有遮蔽所以是不完全訊息. 且在執行時必須同時操控上百個單位, 且每個單位都有非常巨大的行動空間action space以及狀態空間state space, 也需要一起合作達成某個目標. 而且通常某個時間點所下的決策可能對中期或後期的狀態都會造成影響. 這些挑戰都讓我們思考如何轉化問題並有效地應用強化學習在這類問題上.

而在強化學習部分Deepmind也測試了三種不同的agent包括 (1) Atari-net Agent 是之前Atari 及Deepmind使用的基礎agent, 輸入minimap 和screen 的feature map, 以及和空間無關的features, 之後經過linear layer輸出action policies. (2) FullyConv Agent 架構類似只是用上了CNN. 而為了讓agent 能有記憶功能, 第三種為 FullyConv LSTM agent. 不過即使在mini game的強化學習上agent能夠有不錯的表現, 在完整版遊戲上的表現並不好. 可見的在這複雜的環境下強化學習或AI仍有很長一段路要走.